جدای از کاربران اینترنت که ما انسان ها باشیم ربات های مختلفی هم در این بستر وجود دارند. ربات هایی که به صورت روزانه از وبسایت های موجود در سطح وب بازدید به عمل می آورند و از طریق لینک های موجود در آن ها، صفحات را یکی پس از دیگری مورد بررسی قرار می دهند.

ربات هایی که برنامه ریزی شدند تا هر صفحه و هر اطلاعاتی که در این بستر پهناور وجود دارد را بخوانند و به سازنده ی خود گزارش دهند. ربات هایی که اگر برای آن ها خطوط قرمزی کشیده نشود تمام اطلاعات مهم و حساس موجود در یک سایت را می خوانند و به سازنده خود گزارش می دهند.

برای جلوگیری از چنین رخداد هایی برنامه نویسان چاره ی کار را در فایل Robots.txt دیدند. فایلی که مخصوص ربات ها نوشته شده و خطوط قرمز و دسترسی های خزنده ها در آن مشخص شده است.

فایل Robots.txt

فایل Robots.txt قطعه کدی است که توسط مدیر سایت، سئوکار یا طراح، به منظور مهار ربات های بازدید کننده، داخل هاست بارگذاری می شود. فایلی متنی که حاوی مجموعه قوانینی است که خطوط قرمز را به ربات ها نشان می دهد و سطح دسترسی آن ها به بخش های مختلف یک وبسایت را مشخص می کند.

مخاطب اصلی فایل Robots.txt خزنده های موتور های جستجو و به ویژه ربات گوگل است. چرا که این دوستان عزیز بیش از هر ربات دیگری به وبسایت هایی که در بستر اینترنت فعالیت دارند سر می زنند و در صورتی که گزارشی مثبت از یک سایت به سازنده ی خود ارسال کنند، رتبه و اعتبار آن بالا و بالا تر می رود.

فایل Robots.txt دقیقا چه کاری انجام می دهد؟

هر ربات یا خزنده ای که وارد یک سایت می شود بلافاصله یک سیگنال از فایل Robots.txt دریافت می کند که این سیگنال، ربات را ملزم به بررسی کامل فایل Robots.txt می کند. با خواندن این فایل ربات متوجه می شود که چه صفحاتی را می تواند بررسی کند و از ورود به چه صفحاتی منع شده است.

آیا هر سایتی نیاز به فایل Robots.txt دارد؟

بله هر سایتی که در بستر اینترنت فعالیت می کند باید یک فایل Robots.txt داشته باشد. وجود این فایل در هر سایتی از اهمیت ویژه ای برخوردار است و نبود آن می تواند مشکلات مختلفی را برای یک کسب و کار آنلاین به وجود آورد.

اگر سایتی فایل Robots.txt را در پوشه ی public html خود نداشته باشد ربات های بازدید کننده می توانند به هر بخشی که می خواهند ورود کنند و نتایج بررسی های خود را طی یک گزارش به سازنده ی خود ارسال کنند.

اما اگر این فایل در هاست و در پوشه ی public html موجود باشد، خزنده ها چاره ای جز مطالعه و عمل به دستوراتی که در آن نوشته شده ندارند. دستوراتی که به آن های می گوید اجازه ورود به چه بخش هایی را دارند و از چه بخش هایی باید دوری کنند. چه فایل هایی را می توانند بخوانند و حق خواندن چه فایل هایی را ندارند.

چطور فایل Robots.txt را ویرایش کنیم؟

پیش از این که به سراغ روش های ویرایش فایل Robots.txt برویم لازم است به این موضوع اشاره کنیم که اگر از CMS وردپرس برای مدیریت سایت خود استفاده می کنید، یک نمونه ی استاندارد از این فایل به صورت پیشفرض داخل پوشه ی public html وبسایت شما وجود دارد.

پس اگر دانش کدنویسی ندارید بهتر است به همان نسخه ی پیشفرض اکتفا کنید. چون استفاده از نسخه ی پیشفرض این فایل هزاران بار بهتر از استفاده از نسخه ای است که کد های اشتباه در آن موجود باشد. چرا که یک کد اشتباه می تواند به کلی یک وبسایت را نابود کند و آن را از دید موتور های جستجو محو کند.

برای ساخت یا ویرایش این فایل در اولین قدم باید بعد از نام وبسایت خود عبارت Robots.txt (به صورت domain.com/robots.txt) را در مرورگر خود تایپ کنید و دکمه ی اینتر را بزنید. اگر این فایل در هاست شما موجود باشد با صفحه ای رو به رو می شوید که دستورات مخصوص ربات ها در آن نوشته شده است.

در غیر این صورت باید یک فایل با نام robots.txt در پوشه ی public html هاست خود بسازید و کد های مد نظر خود را در آن وارد کنید. این روش راهکاری مرسوم برای ویرایش و ساخت یک فایل Robots.txt است که اکثر مدیران وب از آن برای ابلاغ دستورات به ربات ها استفاده می کنند.

اما اگر کار با هاست را دوست ندارید و می خواهید از داشبورد وردپرس خود این کار را انجام دهید، پیشنهاد تیم آموزش سئو بیا و یادبگیر استفاده از افزونه ی رنک مث سئو است. با مراجعه به بخش تنظیمات عمومی این افزونه ی سئو می تواند به فایل Robots.txt موجود روی هاست دسترسی داشته باشید و دستورات مد نظر خود را در آن وارد کنید.

مهم ترین موارد که هر فایل Robots.txt باید داشته باشد

قرار نیست که فایل Robots.txt محتوای عجیب و زیادی داشته باشد. این فایل به صورت پیشفرض شامل 3 الی 4 خط کد و در صورتی که توسط برنامه نویسان شخصی سازی شده باشد می تواند کمی بیشتر از این مقدار باشد.

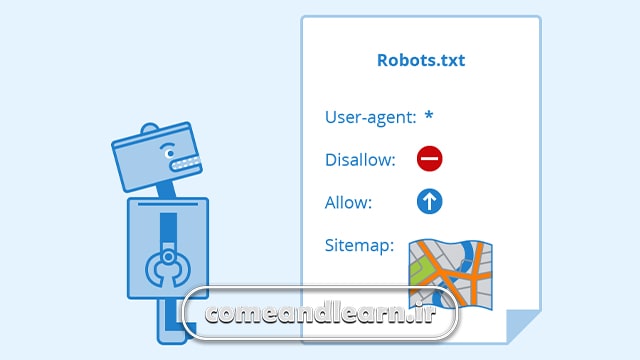

لازم است تا مخاطب خود را در این فایل مشخص کنید. آیا ربات خاصی را در نظر دارید و می خواهید دستورات در خصوص آن خزنده ی خاص اجرایی شود یا این که می خواهید دستوراتی که می نویسید تمامی ربات ها را در بر بگیرد.

باید در این فایل مشخص کنید که مخاطب امکان دسترسی به چه صفحاتی را دارد و از ورود به چه صفحاتی منع شده است. به عنوان مثال بهتر است دسترسی ربات ها به صفحه wp-admin را ببندید تا نتوانند اطلاعاتی را که مدیر سایت به آن ها دسترسی دارد را بخوانند.

همچنین لازم است تا آدرس نقشه سایت خود را در فایل Robots.txt قرار دهید تا ربات ها بلافاصله بعد از خواندن این فایل به سراغ نقشه ی سایت بروند و سریع ترین مسیر را برای رسیدن به مقصد خود انتخاب کنند.

اصطلاحات فایل Robots.txt

-

user-agent

user-agent اولین دستوری است که باید در هر فایل Robots.txt نوشته شود. با کمک این دستور می توانید مخاطب خود را مشخص کنید. اگر قصد دارید تا تمامی ربات ها را خطاب قرار دهید باید از کاراکتر * به این صورت (* : user-agent) استفاده کنید.

اما اگر ربات یا خزنده خاصی را مد نظر دارید و می خواهید دستوراتتان فقط شامل حال آن شود می توانید از به جای کاراکتر * نام ربات را به این صورت (user-agent : GoogleBot) بنویسید. در این مثال تیم آموزش سئو بیا و یادبگیر ربات گوگل را مخاطب خود قرار داده و دستورات فقظ شامل حال آن می شود.

-

Disallow

به صورت پیشفرض ربات ها می توانند به تمامی بخش های یک سایت ورود کنند. اما اگر به هر دلیلی قصد جلوگیری از ورود آن ها به بخش خاصی از وبسایت خود را دارید می توانید از دستور Disallow به صورت (/Disallow : /wp-admin) استفاده کنید. در این مثال تیم آموزش سئو بیا و یادبگیر ربات ها را از ورود به صفحه ادمین منع کرده است.

-

Allow

دستور Allow نقظه ی مقابل دستور Disallow است و می توان با استفاده از آن مجوز ورود ربات ها به یک صفحه ی خاص را صادر کرد. اما تنها زمانی از آن استفاده می شود که بخواهید مسیری را در یک صفحه ی ممنوعه برای ربات ها باز کنید.

به عنوان مثال برای حفظ امنیت سایت با دستور /Disallow : /wp-admin ربات ها را از ورود به صفحه ی ادمین منع می کنیم اما با استفاده از دستور /Allow : /wp-admin/admin-ajax.php اجازه ورود آن ها را به یکی از فایل های موجود در این صفحه می دهیم.

چه فایل هایی نباید مورد بازدید ربات ها قرار گیرند؟

نیازی نیست که ربات ها و خزنده های موتور های جستجو تمامی فایل ها و اطلاعات موجود در یک سایت را بخوانند و آن ها را ایندکس کنند. چون برخی از این اطلاعات هیچ تاثیری در رشد و پیشرفت یک سایت ندارد و خوانده شدن برخی دیگر هم می تواند امنیت یک وبسایت را به خطر بیندازد.

به همین دلیل لازم است تا با استفاده از دستور Disallow و مسدود کردن برخی از مسیر ها در فایل Robots.txt ضمن حفظ امنیت کسب و کار آنلاین خود از افت رتبه ی آن نیز جلوگیری کنید. این مسیر ها عبارتند از:

- صفحه wp-admin اولین صفحه ای است که باید از ورود ربات ها و خزنده های موتور های جستجو به آن جلوگیری شود. این صفحه هیچ ارزشی برای موتور های جستجو ندارد و تنها اطلاعات هویتی مدیران سایت در آن موجود است که برای حفظ امنیت، باید از دید ربات ها مخفی شود.

- صفحات حساب کاربری، صفحاتی که کاربران شما اطلاعاتی مثل شماره ی تماس، ایمیل و نام کاربری و از این قبیل اطلاعات را در آن ثبت می کنند به هیچ عنوان نباید در دستر ربات ها و خزنده های موتور های جستجو قرار بگیرد. چون حفظ امنیت کاربران از اولویت های داشتن یک کسب و کار آنلاین و پایدار است.

- بهتر است صفحات تکراری یا صفحات با محتوای بی ارزش را نیز از دسترس ربات ها دور نگه دارید. چون بررسی شدن این صفحات برای یک سایت چیزی جز ضرر ندارد و باعث افت رتبه و اعتبار آن می شود.

کلام آخر

مطالب در خصوص فایل Robots.txt بسیار بیشتر از چیزی است که در این مقاله به آن اشاره شد. پس بر این باور نباشید که با مطالعه ی این مقاله به طور کامل به نحوه ی کار این فایل مسلط شدید و دیگر نیازی به یادگیری مطالب جدید در این خصوص ندارید.

تمامی مطالبی که در این مقاله به آن اشاره شد تنها پیش زمینه درباره ی فایل Robots.txt بود و تیم آموزش سئو بیا و یادبگیر سعی کرده تا مطالب پایه ای را در این باره برای شما بازگو کند تا بتوانید نیاز های اولیه وبسایتتان را به دست خودتان مرتفع کنید.

اما اگر هنوز هم نقطه ی تاریکی در این خصوص در ذهن شما باقی مانده و سوالی دارید خوشحال می شویم که آن ها را در بخش نظرات مطرح کنید تا پاسخگوی شما باشیم.